Attualità

C’è più del 50% delle possibilità che la AI distrugga l’umanità. Questo è il risultato di una recente ricerca economica

A marzo analisti di Goldman Sachs avevano previsto che lpintroduzione approfondita della Ai e la sua continua evoluzione avrebbe rivoluzionato il mondo del lavoro, spazzando via gran parte delle attività nel settore dei servizi e professionali.

In particolare, secondo Jan Hatzius, “utilizzando i dati sulle mansioni professionali sia negli Stati Uniti che in Europa, abbiamo scoperto che circa due terzi dei lavori attuali sono esposti a un certo grado di automazione dell’IA e che l’IA generativa potrebbe sostituire fino a un quarto dei lavori attuali. Estrapolando le nostre stime a livello globale, si evince che l’IA generativa potrebbe esporre all’automazione l’equivalente di 300 milioni di posti di lavoro a tempo pieno”, in quanto fino a “due terzi delle occupazioni potrebbero essere parzialmente automatizzati dall’IA”.

E mentre Goldman fa tutto il possibile per far passare i dati in una luce positiva, con i licenziamenti di massa compensati da “un boom della produttività del lavoro che aumenterà significativamente la produzione globale”, con l’adozione diffusa dell’IA che alla fine porterà a un aumento del 7%, o quasi 7 trilioni di dollari, del PIL globale annuale in un periodo di 10 anni.

Tuttavia, per quanto 7 trilioni di dollari possano sembrare un’ottima cifra… dovremmo sopravvivere per goderne (e con “noi” intendiamo “tutta l’umanità”) ed è qui che l’ultimo rapporto di BCA Research ha una visione pessimista: il problema è tutto legato all’entropia, alla seconda legge della termodinamica e alla sua applicazione a ChatGPT

Cosa dice il terrificante rapporto BCA research

I rischi per la sicurezza legati all’IA sono enormi e riteniamo che ci sia una probabilità superiore al 50% che l’IA possa spazzare via l’intera umanità entro la metà del secolo.

I ragionamenti di BCA Research

La maggior parte delle discussioni sull’IA estrapolano linearmente ciò che l’IA può fare oggi da ciò che potrà fare domani. Ma la progressione dell’IA segue una curva esponenziale, non lineare, il che significa che i progressi potrebbero essere molto più rapidi del previsto.

L’IA è diversa

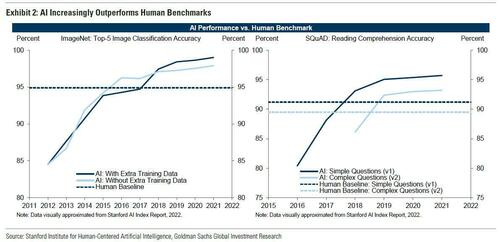

Se l’IA segue la stessa traiettoria di altre grandi rivoluzioni tecnologiche, è possibile che l’IA non produca importanti aumenti di produttività a livello economico prima degli anni 2030 o più tardi.

Detto questo, ci sono ragioni per pensare che l’impatto dell’IA potrebbe arrivare molto prima. Un recente studio di Erik Brynjolfsson e dei suoi coautori ha rivelato che la produttività è aumentata del 14% tra gli addetti al servizio clienti di una grande azienda di software dopo che è stato dato loro accesso a strumenti di intelligenza artificiale generativa.

Il problema di queste precedenti rivoluzioni tecnologiche è che erano incentrate sull’applicazione e sulla diffusione di conoscenze preesistenti. Al contrario, la rivoluzione dell’intelligenza artificiale ha il potenziale per portare alla creazione di nuova conoscenza – una conoscenza generata dalle macchine piuttosto che dagli esseri umani.

A dire il vero, questo non è ancora accaduto. ChatGPT funziona ancora come una funzione di autocompletamento, utilizzando il suo algoritmo per aggiungere una parola dopo l’altra, una frase dopo l’altra, a un dialogo in corso da un’enorme libreria di testi. Tuttavia, anche con questa funzionalità limitata, è riuscita a mostrare ciò che un recente documento di ricerca di Microsoft ha descritto come “scintille” di intelligenza artificiale generale. Mentre la frenesia degli investimenti sull’IA è già iniziata, l’impatto economico dell’IA non è ancora visibile nei dati sulla produttività…

L’ultima cosa che gli esseri umani inventeranno mai

Il fatto che le menti dell’IA non siano affatto simili a quelle umane è irrilevante. Un aereo non assomiglia a un uccello. Eppure, il primo può ancora volare molto più velocemente del secondo.

Se modelli come ChatGPT raggiungeranno mai il punto in cui possono addestrarsi da soli – un po’ come AlphaZero di Deepmind può addestrarsi a padroneggiare gli scacchi senza che gli siano mai state insegnate le regole del gioco – allora saranno in grado di migliorarsi ricorsivamente a una velocità elevatissima. In un certo senso, questo sta già accadendo.

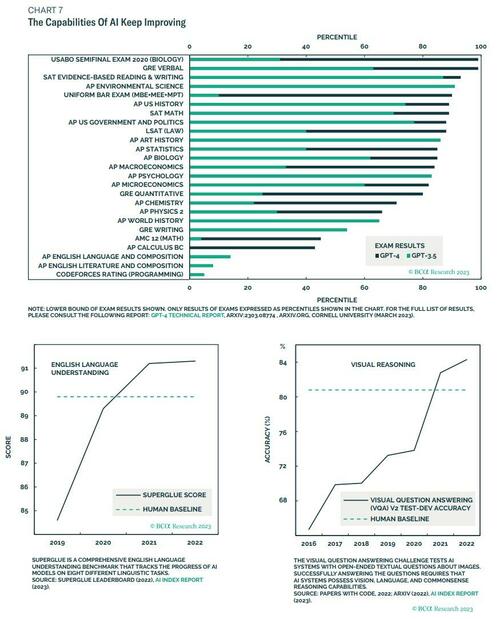

Immaginate un’intelligenza in grado di evolvere da un QI iniziale di 1. Ci vorrebbero cinque raddoppi per raggiungere un QI di 32, che è ancora troppo basso per funzionare in un mondo tecnologico moderno. Ma basterebbero altri tre raddoppi per raggiungere un QI di 256, che è di gran lunga superiore al QI di qualsiasi essere umano mai vissuto. L’intelligenza artificiale è migliorata in modo esponenziale per molti anni, ma solo ora abbiamo raggiunto il punto della curva in cui può superare gli esseri umani in un’ampia gamma di compiti cognitivi (Grafico 7).

Ciò evidenzia una lacuna fondamentale della maggior parte delle discussioni sul probabile impatto dell’IA sulla società e sull’economia. Esse estrapolano linearmente da ciò che l’IA può fare oggi a ciò che potrà fare domani. Ma la progressione dell’IA segue una curva esponenziale, non lineare, il che significa che i progressi potrebbero essere molto più rapidi del previsto. In effetti, la progressione dell’IA sarà probabilmente iperesponenziale, con il tempo che intercorre tra un raddoppio delle prestazioni e l’altro che si riduce da anni a settimane o addirittura ore. Proprio come la comunità degli investitori e il pubblico in generale sono stati sorpresi dall’aumento esponenziale dei casi durante i primi giorni della pandemia, saranno sorpresi dalla rapidità con cui l’IA trasformerà il mondo che ci circonda.

Una fase di transizione

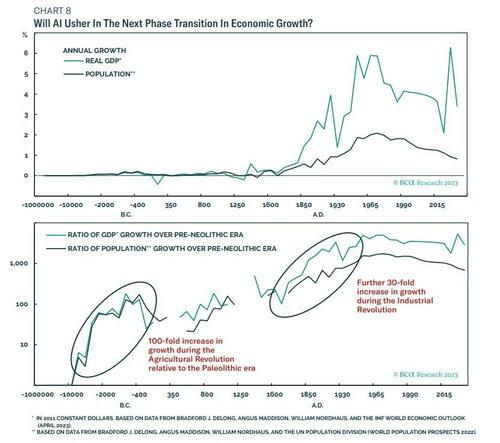

In questio momento l’umanità potrebbe essere vicina ad una transizione di fase, da un’era tecnologica a un’altra, di cui non sappiamo ancora molto, ma, per fare una previsione, possiamo rivolgerci alle evidenze storiche.

La popolazione umana è cresciuta a malapena fino all’avvento dell’agricoltura, intorno al 10.000 a.C.. Dopo la rivoluzione agricola, la crescita della popolazione mondiale è accelerata a circa il 2,5% per secolo. Con l’inizio della rivoluzione industriale, la crescita della popolazione globale è balzata di 40 volte all’1% all’anno. Quando l’umanità è finalmente uscita dalla trappola malthusiana, il reddito pro capite ha iniziato a crescere molto più rapidamente della popolazione. Dal 1800, il PIL globale è aumentato del 2,8% all’anno, per un incremento cumulativo del 50.000%.

Se l’umanità sopravvive alla transizione verso un’intelligenza artificiale superintelligente, l’impatto sulla crescita potrebbe essere paragonabile a quello che si è verificato prima durante la rivoluzione agricola e poi durante la rivoluzione industriale. Entrambe le rivoluzioni hanno registrato un aumento del PIL da 30 a 100 volte rispetto all’epoca precedente.

Prolifereranno nuove tecnologie e nuove industrie. Problemi che un tempo sembravano intrattabili, come il modo di fermare e invertire l’invecchiamento, potrebbero essere risolti da un giorno all’altro. Prima di ChatGPT, sembrava improbabile che una simile transizione di fase potesse iniziare a breve. Ora è probabile che avvenga entro la fine del decennio.

Il Bilancio dellla ricerca BCA è il seguente: A differenza delle passate rivoluzioni tecnologiche, l’impatto dell’IA superintelligente potrebbe arrivare rapidamente. Darà vita a un’era di prosperità senza precedenti o ci trasformerà tutti in relitti del passato

Ed è qui che la ricerca di BCA prende una piega più oscura…

“Apri le porte dell’are dei Pod, Hal”

Sopravviveremo alla transizione verso la superintelligenza? Purtroppo le probabilità non sono buone. La questione principale è incentrata sul cosiddetto problema dell’allineamento: come allineare i nostri obiettivi con quelli dell’IA.

Ogni sistema di IA deve avere un obiettivo da perseguire, senza il quale non saprebbe come utilizzare le proprie risorse. Nel caso di ChatGPT, tale obiettivo viene inserito dall’utente come prompt. Nel caso di IA più elaborate, come AutoGPT, gli obiettivi potrebbero essere più aperti e vari.

L’elenco di tutti i possibili obiettivi che un’intelligenza artificiale può perseguire è enorme, ma solo un minuscolo sottoinsieme di quelli che la maggior parte degli esseri umani vorrebbe mai vedere realizzati. E anche all’interno di questo piccolo sottoinsieme, far sì che un’IA raggiunga un obiettivo nel modo in cui è stato originariamente concepito potrebbe rivelarsi estremamente difficile.

La maledizione della seconda legge della termodinamica

Le leggi della fisica non hanno una direzione preferita per il tempo. Il motivo per cui percepiamo il flusso del tempo è la Seconda Legge della Termodinamica, che afferma che l’entropia aumenta quasi sempre nella direzione che chiamiamo futuro.

Un sistema ad alta entropia ha più evoluzioni possibili di un sistema a bassa entropia. Se si vede una foto di un uovo rotto e una foto dello stesso uovo non rotto, si può dire quale foto è stata scattata per prima perché l’ordine entropico dell’uovo intero è superiore a quello dell’uovo rotto. Inoltre l’uovo si può rompere in molti modi diversi, perché possiamo avere una disposzione dei frammenti quasi infinita, mentre l’ordine di partenza dell’uovo prima della rottura era unica.

Una delle conseguenze della Seconda Legge è che è molto più facile distruggere che creare. Tale distruzione può avvenire inavvertitamente, come se ci sfugge di mano un uovo, oppure intenzionalmente. In ogni caso, potrebbe essere difficile evitare l’annientamento. Inoltre la rottura può avvenire verso un’innumerevole numero di alternative, mentre l’ordine giusto è solo uno.

Il settore della sicurezza delle AI dovrà crescere in modo enorme

Secondo una stima, dal 1970 l’umanità ha spazzato via il 60% degli animali vertebrati. Non abbiamo mai deciso di ucciderli di proposito. È stato solo un sottoprodotto dell’espansione economica del pianeta. Il rischio è che il contatto con un’IA più intelligente possa portare anche alla nostra estinzione.

Il 22 marzo, il Future of Life Institute ha pubblicato una lettera firmata da oltre 1.000 personalità, tra cui Elon Musk e il cofondatore di Apple Steve Wozniak, in cui si chiede una pausa di sei mesi nella ricerca sulle IA per avere più tempo per sviluppare migliori protocolli di sicurezza.

Finora, l’industria dell’IA è stata estremamente cauta nei confronti dei problemi di sicurezza. La situazione è destinata a cambiare, dato che la preoccupazione per i rischi posti dall’IA continua ad accumularsi. Prima di sviluppare la AI bisogna avere dei meccanismi che evitino che questa cancelli l’umanita, e quessti meccanismi ancora non esistono. Forse neppure basterebbero sei mesi per crearli.

Grazie al nostro canale Telegram potete rimanere aggiornati sulla pubblicazione di nuovi articoli di Scenari Economici.

You must be logged in to post a comment Login