Finanza

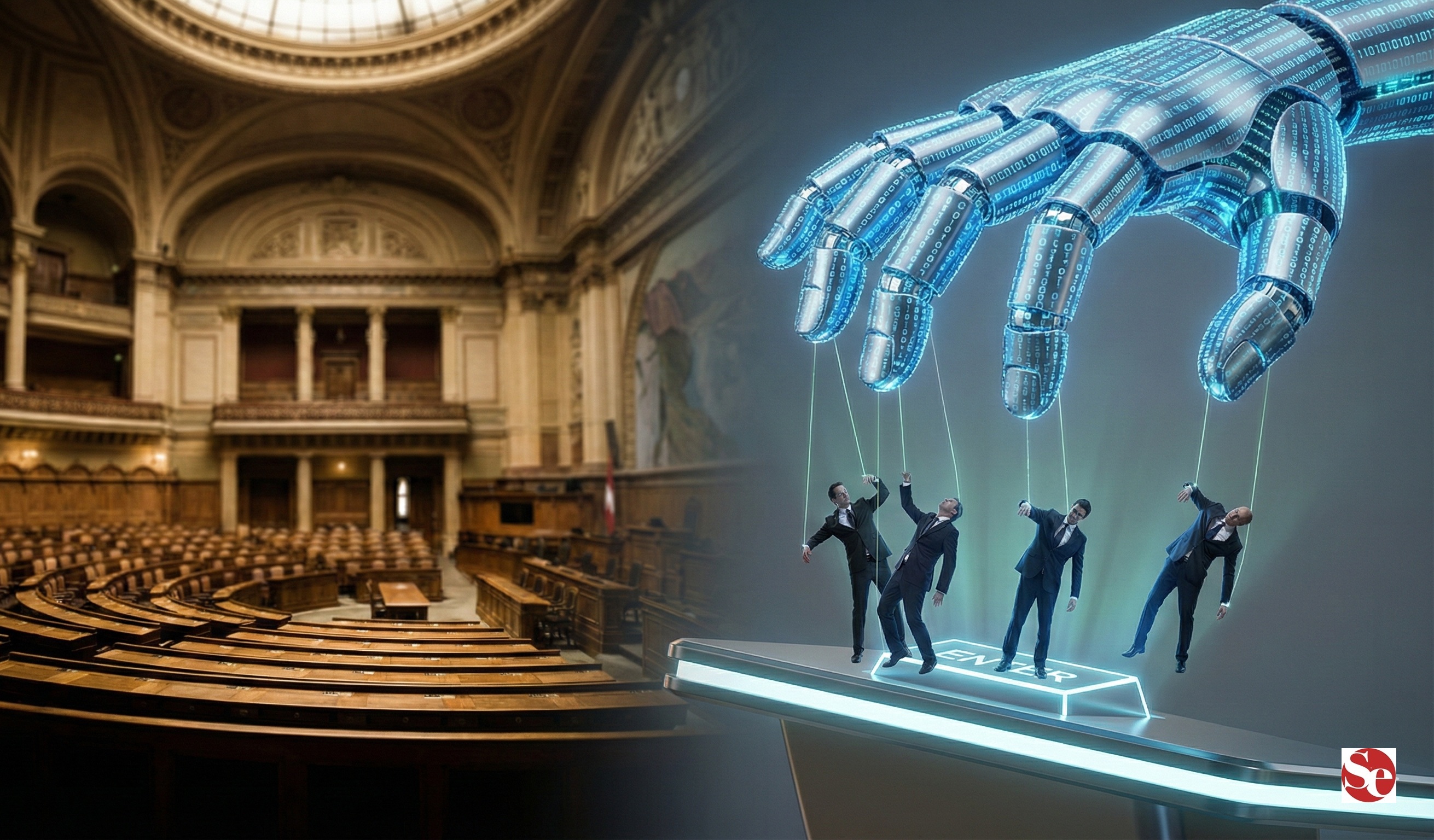

Algoritmi, razionalità tecnica e crisi della responsabilità del potere politico (di Antonio Maria Rinaldi)

Rinaldi: l’inganno degli algoritmi “neutrali”. Ecco come la tecnica sta cancellando la responsabilità politica e perché la democrazia rischia di diventare una scatola vuota.

La fase attuale dello sviluppo economico e istituzionale è caratterizzata da una progressiva traslazione del processo decisionale verso sistemi algoritmici, ai quali viene attribuito un ruolo crescente nella regolazione dei comportamenti individuali e collettivi. Tali sistemi intervengono ormai in modo pervasivo nell’allocazione delle risorse, nella valutazione del rischio, nella selezione del capitale umano, nella gestione dei mercati e, con frequenza sempre maggiore, nel supporto – se non nella determinazione – delle decisioni pubbliche. Questa evoluzione viene comunemente rappresentata come una conseguenza inevitabile del progresso tecnologico e come una risposta razionale alla complessità dei sistemi contemporanei. Si tratta, tuttavia, di una rappresentazione riduttiva, che tende a occultare implicazioni teoriche e istituzionali di rilievo, in particolare sul piano della responsabilità del potere politico.

Il principale errore concettuale risiede nell’attribuzione agli algoritmi di una presunta neutralità scientifica. In realtà, ogni algoritmo costituisce una formalizzazione di ipotesi, criteri di selezione e funzioni-obiettivo definite ex ante. Esso incorpora inevitabilmente una specifica visione del mondo, riflettendo le priorità normative di chi lo progetta e le distorsioni presenti nei dati utilizzati per il suo addestramento. La trasformazione del giudizio in calcolo non elimina l’arbitrarietà della decisione, ma la dissimula sotto una veste matematica, conferendole una legittimità tecnica che tende a sottrarla al confronto critico e alla deliberazione pubblica, elementi costitutivi della decisione politica.

A ciò si aggiunge un problema strutturale di opacità. I modelli algoritmici più avanzati operano secondo logiche non immediatamente interpretabili, generando esiti decisionali privi di una spiegazione intelligibile per i soggetti coinvolti. Quando scelte che incidono sui diritti fondamentali, sulle opportunità economiche o sulla reputazione sociale degli individui vengono affidate a sistemi non trasparenti, si produce una frattura tra decisione e responsabilità. In questo passaggio, la responsabilità politica tende a dissolversi: la decisione viene percepita come “tecnicamente necessaria”, mentre il decisore si limita a ratificarne l’esito, indebolendo i meccanismi di accountability democratica.

Un ulteriore profilo critico riguarda la natura sistemica dell’errore algoritmico. L’errore umano è per sua natura circoscritto e potenzialmente correggibile; l’errore incorporato in un algoritmo, al contrario, tende a replicarsi automaticamente su larga scala. In presenza di meccanismi di retroazione, l’errore non solo persiste, ma si consolida nel tempo, trasformandosi in criterio operativo stabile. Nei mercati finanziari, nei sistemi di credito o nelle politiche di welfare, ciò può tradursi in dinamiche di esclusione e rigidità che, proprio perché tecnicamente mediate, sfuggono al controllo politico diretto.

La diffusione degli algoritmi comporta inoltre una progressiva compressione dello spazio decisionale umano. Il decisore pubblico viene indotto ad adeguarsi all’output algoritmico, percepito come soluzione ottimale e oggettivamente fondata. Si afferma così una forma di eteronomia decisionale, nella quale il giudizio politico si riduce a mera esecuzione di vincoli tecnici. La razionalità strumentale finisce per prevalere sulla responsabilità sostanziale, producendo una crisi silenziosa del ruolo del potere politico come luogo della scelta e dell’assunzione di responsabilità.

Non meno rilevante è la questione del potere informativo. Il controllo degli algoritmi e dei dati è concentrato in un numero ristretto di soggetti, mentre la collettività subisce gli effetti delle decisioni senza disporre degli strumenti cognitivi e istituzionali per comprenderne il funzionamento. Si configura così una nuova asimmetria di potere, fondata non sulla titolarità formale delle decisioni, ma sulla capacità di orientarle indirettamente attraverso modelli matematici opachi.

Il rischio ultimo è di natura propriamente istituzionale. Delegare sistematicamente agli algoritmi significa trasformare scelte intrinsecamente politiche in problemi tecnici, sottraendole al conflitto, al confronto e alla responsabilità democratica. Una decisione presentata come tecnicamente inevitabile diventa, per definizione, indiscutibile. In tal modo, la tecnica non governa più la complessità, ma finisce per governare la politica stessa.

Il progresso tecnologico non può essere arrestato, ma deve essere ricondotto entro un quadro di responsabilità umana e politica. Gli algoritmi devono rimanere strumenti di supporto alla decisione, non sostituti del giudizio politico. Una società che abdica alla responsabilità in nome dell’efficienza rischia di apparire formalmente razionale, ma di rivelarsi, nel lungo periodo, istituzionalmente fragile. È su questo equilibrio che si gioca oggi la tenuta delle democrazie avanzate.

Domande e risposte

Gli algoritmi sono davvero neutrali e oggettivi come ci dicono? Assolutamente no. Questa è la principale mistificazione dell’era digitale. Ogni algoritmo incorpora la visione del mondo, i pregiudizi e le priorità di chi lo ha programmato e dei dati su cui è stato addestrato. Presentare un risultato algoritmico come “scienza neutrale” serve solo a nascondere la natura politica e arbitraria della scelta, sottraendola alla critica democratica. La matematica, in questo caso, è solo un vestito elegante per decisioni che restano umane.

Perché l’uso massiccio di algoritmi mette a rischio la responsabilità politica? Perché crea un comodo alibi. Quando una decisione impopolare o complessa viene delegata a un sistema automatizzato opaco, il politico può allargare le braccia e dire “lo dice il sistema”, “è tecnicamente necessario”. In questo modo si spezza il legame tra decisore ed elettore. La responsabilità si dissolve in una “necessità tecnica” che rende impossibile l’accountability democratica, trasformando i rappresentanti del popolo in semplici esecutori di vincoli esterni.

Qual è la differenza tra un errore umano e un errore algoritmico? La differenza sta nella scala e nella persistenza. L’errore di un funzionario o di un politico è solitamente circoscritto e si può correggere caso per caso. L’errore di un algoritmo, invece, è sistemico: si replica istantaneamente su migliaia o milioni di decisioni, consolidandosi nel tempo grazie ai meccanismi di retroazione. Nei mercati finanziari o nel welfare, questo può creare spirali di esclusione o crisi sistemiche che sfuggono al controllo diretto della politica prima che sia troppo tardi.

You must be logged in to post a comment Login