Economia

Amazon lancia la sfida del silicio: arriva Trainium3. Efficienza a 3nm per sgonfiare la bolla dei costi AI

Amazon sfida Nvidia e lancia Trainium3: il nuovo chip a 3nm che promette di dimezzare i costi dell’Intelligenza Artificiale e potenziare i rivali di ChatGPT.

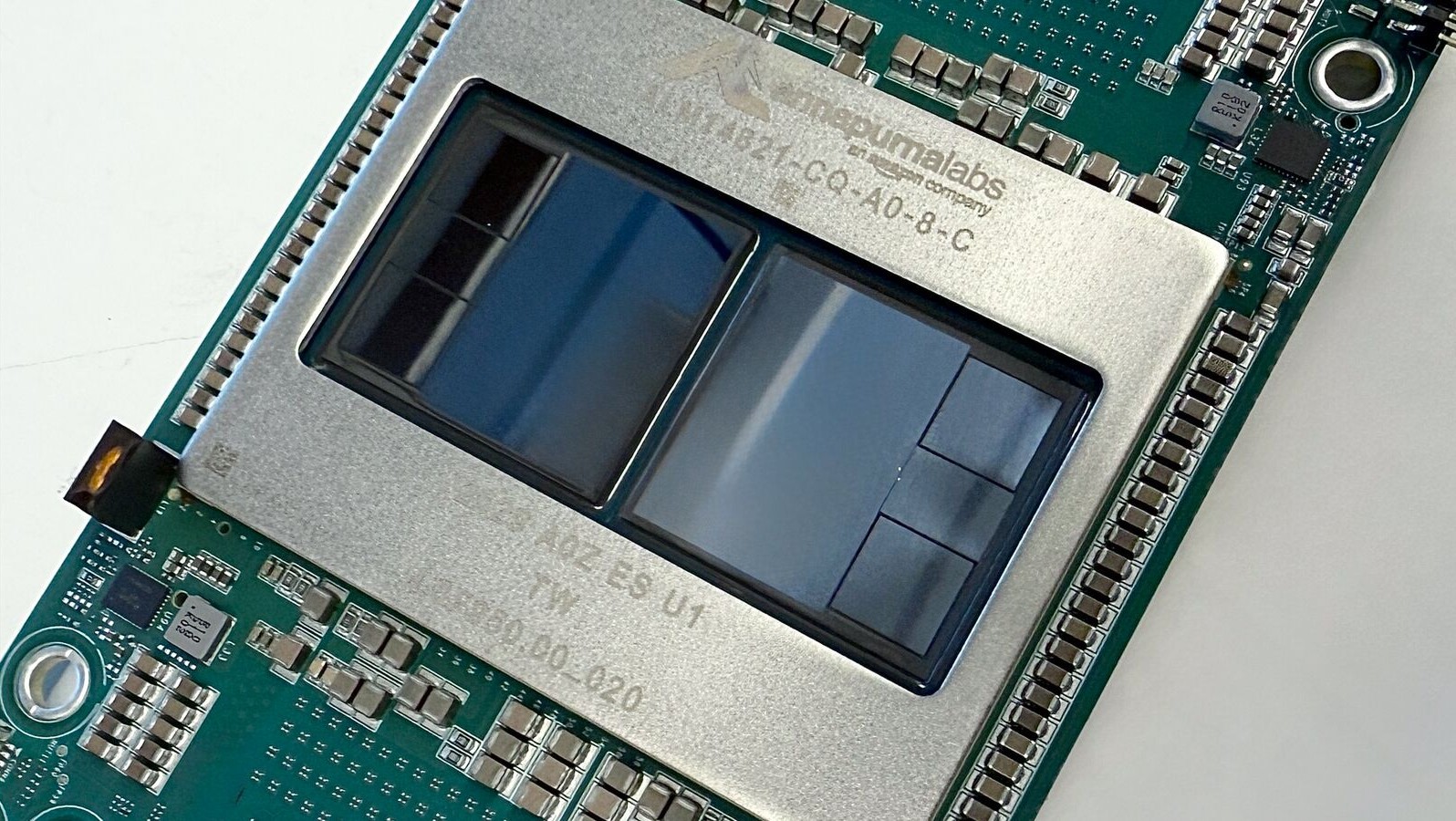

Mentre il mondo si accapiglia per accaparrarsi le costosissime GPU di Nvidia e gli investitori scrutano con ansia i bilanci delle Big Tech appesantiti dalle spese in conto capitale (Capex), Amazon gioca la sua carta più pesante. Non si tratta di un nuovo modello linguistico, ma del “motore” che sta sotto il cofano: AWS Trainium 3. Esso 3 la dimensione in nanometri, il 3 è meglio del 4…

Presentato al re:Invent, il nuovo chip proprietario a 3 nanometri non è solo un esercizio di stile ingegneristico, ma una mossa squisitamente economica e strategica. L’obiettivo? Abbattere drasticamente i costi di addestramento e inferenza dell’Intelligenza Artificiale, democratizzando l’accesso a risorse che oggi sono appannaggio di pochi eletti.

La risposta di Amazon alla “Guerra dei Chip”

Siamo onesti: l’attuale modello di sviluppo dell’AI, basato su cluster di GPU sempre più grandi e costosi, sta diventando insostenibile per molti. Amazon lo sa e, con il pragmatismo che la contraddistingue, ha deciso di costruirsi l’infrastruttura in casa.

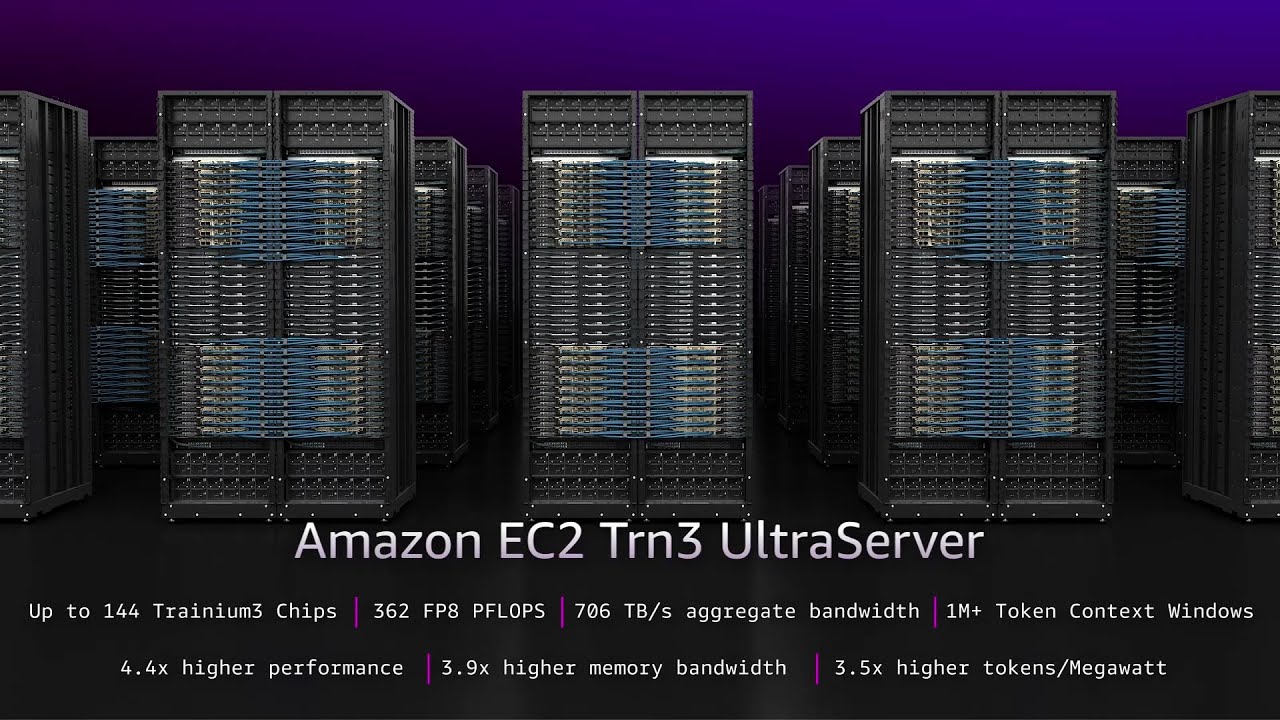

Il Trainium3 è il cuore dei nuovi UltraServers Trn3. Non si tratta di semplici aggiornamenti, ma di un salto generazionale pensato per l’efficienza scalabile. Ecco i dati salienti, depurati dal marketing, che interessano chi guarda alla produttività:

- Potenza di calcolo: Fino a 4,4 volte superiore rispetto alla generazione precedente (Trainium2).

- Efficienza energetica: Un miglioramento del 40%. In un’epoca in cui i data center consumano come piccole nazioni, questo è il dato che fa sorridere i CFO.

- Densità: Ogni server ospita fino a 144 chip Trainium3, creando un sistema integrato capace di gestire modelli massicci.

- Networking: Latenza ridotta sotto i 10 microsecondi tra i chip, essenziale per i modelli Mixture-of-Experts (MoE) che richiedono un flusso dati istantaneo.

L’impatto economico: meno costi, più concorrenza

La vera notizia non è tanto nei FLOPS, quanto nel portafoglio. Clienti come Anthropic (i creatori di Claude, rivale di ChatGPT), ma anche realtà emergenti come Decart e Splash Music, stanno già utilizzando Trainium riducendo i costi fino al 50%.

Questo crea un effetto a catena interessante:

- Indipendenza da Nvidia: Amazon riduce la sua dipendenza (e quella dei suoi clienti) dal fornitore monopolista di fatto, Nvidia, migliorando i margini.

- Abbassamento delle barriere all’ingresso: Se l’inferenza costa la metà, nascono nuovi modelli di business (es. video generativi in tempo reale) che prima erano economicamente in perdita.

- Infrastruttura per tutti: Con gli EC2 UltraClusters, AWS può connettere fino a un milione di chip. È la potenza di fuoco necessaria per addestrare i modelli di fondazione del futuro, non più riservata solo a chi ha budget illimitati.

Uno sguardo al futuro: Trainium4 e l’apertura a Nvidia

Con una mossa che potremmo definire “realpolitik tecnologica”, Amazon ha già anticipato Trainium4. La sorpresa? Supporterà la tecnologia NVLink Fusion di Nvidia. Questo significa che Amazon, pur competendo sul silicio, permetterà di mescolare nei rack i propri chip con quelli di Nvidia. Un approccio ibrido e pragmatico: se non puoi batterli del tutto, falli funzionare meglio sulla tua piattaforma.

Domande e risposte

Cos’ha di nuovo il chip di Amazon per AWS rispetto al mercato? La novità principale è il processo produttivo a 3nm, che garantisce una densità e un’efficienza energetica superiori. A differenza delle GPU generaliste (come quelle Nvidia), Trainium3 è un ASIC, cioè un chip disegnato su misura specificamente per l’AI. Questo permette di eliminare il “grasso” inutile nell’architettura, offrendo prestazioni mirate (4,4x di performance in più rispetto al modello precedente) e, soprattutto, un costo operativo dimezzato per chi deve addestrare modelli pesanti.

Può mettere in difficoltà Gemini e ChatGPT? Direttamente no, ma indirettamente è una spina nel fianco. Gemini gira sui chip proprietari di Google (TPU), mentre ChatGPT si appoggia principalmente all’infrastruttura Microsoft/Nvidia. Trainium3, tuttavia, è l’arma che Amazon fornisce ai rivali di Gemini e ChatGPT (come Anthropic/Claude). Abbassando drasticamente i costi di addestramento e inferenza per questi concorrenti, Amazon alimenta la competizione, costringendo Google e OpenAI a non sedersi sugli allori dei loro margini attuali.

Si tratta di un ASIC che segue quello fatto da Google e venduto a META? Sì, concettualmente è la stessa strada. Google ha i suoi TPU (Tensor Processing Units) da anni, e Meta sta sviluppando i suoi chip MTIA. Trainium3 è l’ASIC (Application Specific Integrated Circuit) di Amazon. La differenza è che mentre Google usa i TPU principalmente per sé (e li affitta su Cloud), Amazon sta spingendo aggressivamente Trainium come standard di mercato per tutti i suoi clienti AWS, cercando di rompere il monopolio di fatto delle GPU Nvidia nel cloud.

You must be logged in to post a comment Login