Economia

Il trono di Nvidia trema? Meta corteggia Google e la rivoluzione silenziosa dei chip TPU

Meta tratta con Google per i chip AI: perché il dominio di Nvidia è a rischio e come le TPU stanno cambiando l’economia del Cloud

C’è un vecchio detto nei mercati finanziari: quando tutti scavano per l’oro, l’unico che si arricchisce davvero è chi vende le pale. Fino a ieri, quel venditore di pale indiscusso, monopolista e venerato era Nvidia. Tuttavia, notizie recenti suggeriscono che i minatori – in questo caso i giganti del Big Tech – stanno iniziando a forgiarsi le pale da soli, o peggio, a comprarle dal vicino di casa.

Il titolo di Nvidia Corp. ha subito uno scossone dopo che The Information ha riportato una notizia che ha fatto drizzare le antenne a Wall Street: Meta Platforms Inc. (Facebook) è in trattative avanzate per spendere miliardi sui chip AI proprietari di Google. Una mossa che suggerisce come il leader della ricerca online stia guadagnando terreno critico nel tentativo di creare un’alternativa credibile all’acceleratore AI più venduto del settore.

Il titolo Nvidia ha risposto male a questa notizia, per la nascita di un nuovo concorrente molto minaccioso:

Questa non è solo una notizia di borsa; è un segnale di un cambiamento tettonico nella struttura dei costi e dell’infrastruttura dell’Intelligenza Artificiale.

Vediamo di capire perché, con la calma e l’analisi della tecnologia alla base di questa scelta cosa viene a cambiare e come Google possa proporre un’alternativa ai GPU di Nvidia per la AI.

La notizia: Zuck chiama Mountain View

Secondo le indiscrezioni, Meta starebbe discutendo per utilizzare i chip di Google – noti come Tensor Processing Units (TPU) – nei propri data center a partire dal 2027. Ma non solo: Meta potrebbe iniziare ad affittare questi chip dalla divisione cloud di Google già dal prossimo anno.

La reazione del mercato è stata immediata e da manuale:

- Le azioni di Alphabet Inc. (Google) hanno guadagnato terreno (+2,7% in late trading).

- Nvidia ha accusato il colpo, scivolando in parallelo.

- I fornitori asiatici di Google, come la sudcoreana IsuPetasys e la taiwanese MediaTek, hanno registrato balzi a doppia cifra.

Perché è importante? Perché un accordo del genere aiuterebbe a stabilire le TPU come una reale alternativa ai chip di Nvidia, che oggi rappresentano il “gold standard” per tutti, da OpenAI a Microsoft. Google ha già siglato un accordo simile con Anthropic, ma portare a bordo un “balena” come Meta – che prevede capex (spese in conto capitale) per oltre 100 miliardi di dollari nel 2026 – è una validazione industriale di un altro livello.

TPU vs GPU: La battaglia dell’efficienza

Per comprendere la portata economica di questa mossa, dobbiamo scendere, brevemente e senza tecnicismi eccessivi, nella sala macchine.

Il dominio di Nvidia si basa sulle GPU (Graphics Processing Units). Nate per i videogiochi e il rendering grafico, si sono rivelate eccellenti per l’AI grazie alla loro capacità di calcolo parallelo. Tuttavia, le GPU si portano dietro un “bagaglio architettonico”: sono generaliste. Devono saper gestire texture, ray-tracing e calcoli fisici.

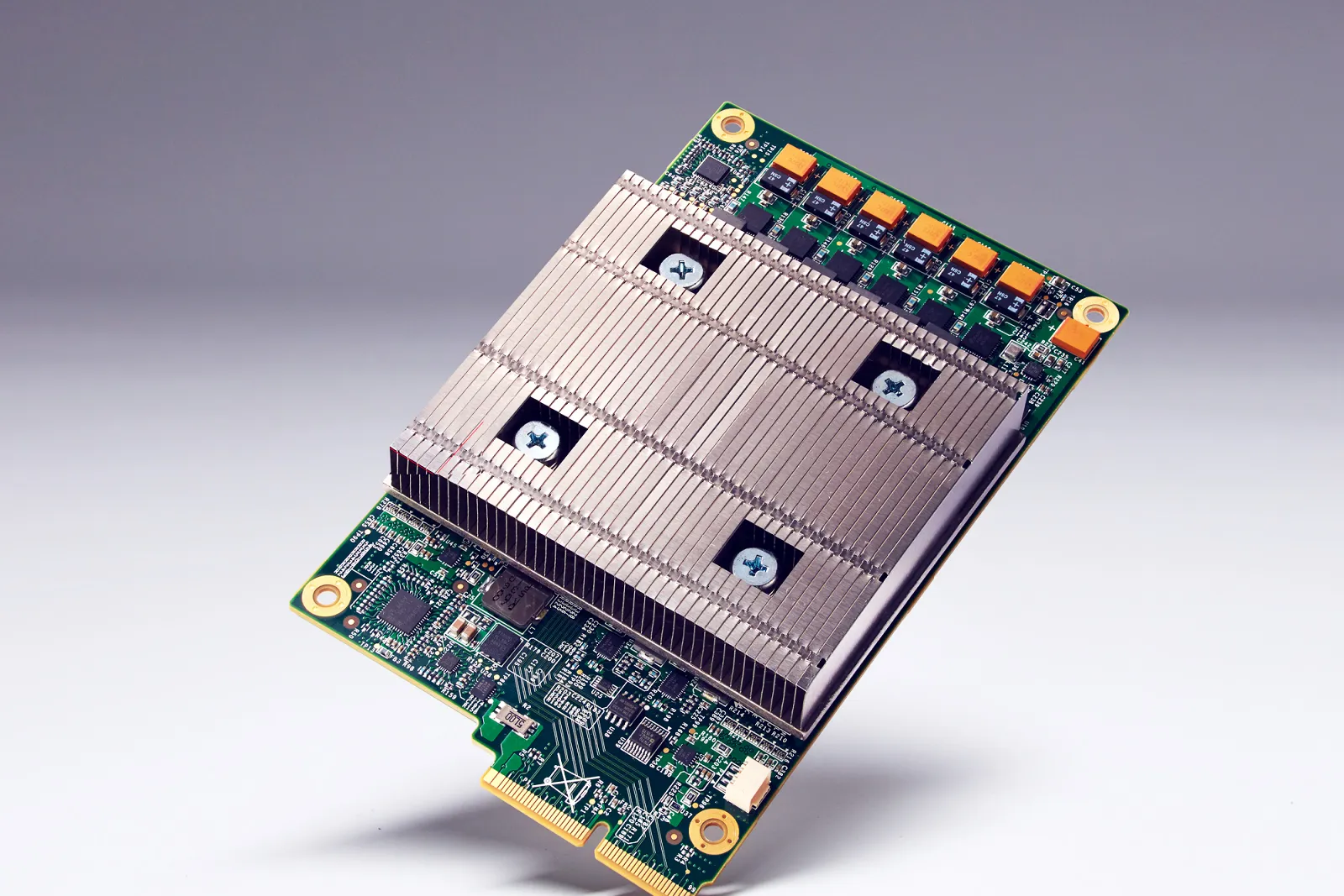

Le TPU (Tensor Processing Units) di Google, invece, sono ASIC (Application-Specific Integrated Circuits). Sono chip progettati a tavolino, sin dal 2013, per fare una sola cosa: calcoli tensoriali per le reti neurali.

Ecco le differenze sostanziali in termini economici e tecnici:

| Caratteristica | GPU (Nvidia) | TPU (Google) |

| Natura | General-purpose (coltellino svizzero) | Domain-specific (bisturi) |

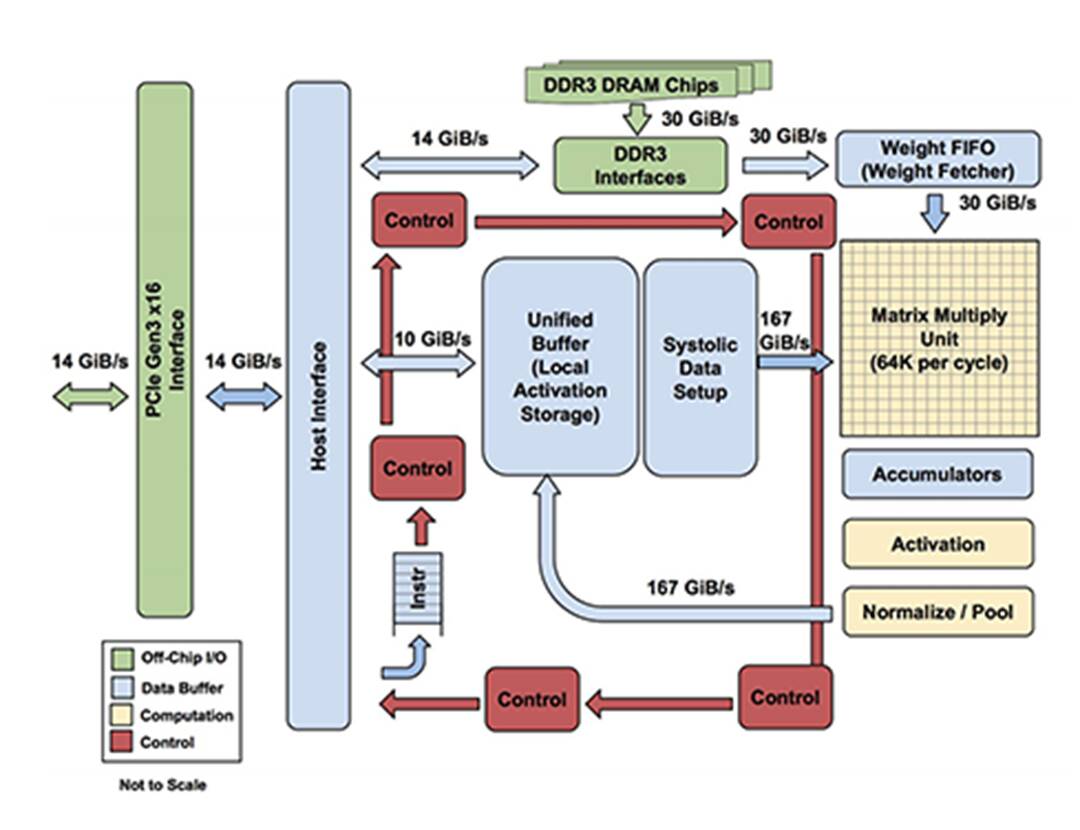

| Architettura | Gestione complessa della memoria, cache, thread | “Systolic Array” (flusso dati continuo come il sangue nel cuore) |

| Efficienza | Alta potenza, ma consumi elevati | Ottimizzato per massimizzare le “Operazioni per Joule” |

| Costo | Margini elevatissimi per Nvidia (fino al 75%) | Costo di produzione inferiore, margine recuperato dal Cloud Provider |

| Ecosistema | CUDA (standard industriale, flessibile) | JAX/TensorFlow (potente ma più chiuso) |

La differenza chiave risiede nell’architettura “sistolica” della TPU. Invece di leggere e scrivere continuamente dati dalla memoria (il collo di bottiglia classico dell’informatica), la TPU fa fluire i dati attraverso una griglia di moltiplicatori in un colpo solo. Risultato? Meno energia, più calcolo netto.

L’economia dello “Scale-Out”: Perché Google fa paura

La storia delle TPU nasce da un calcolo economico fatto dai vertici di Google (Jeff Dean in testa) nel 2013: se ogni utente Android avesse usato i comandi vocali per 3 minuti al giorno, Google avrebbe dovuto raddoppiare i suoi data center. Una spesa insostenibile. La soluzione non era comprare più chip, ma costruire chip migliori.

Oggi, con l’AI generativa, siamo allo stesso punto, il rischio è quello di trovarsi di fronte a costi energetici insostenibili per fornire i servizi necessari.

Gli analisti stimano che le TPU di ultima generazione (v6 e la recente v7 “Ironwood”) offrano un rapporto performance/prezzo nettamente superiore per specifici carichi di lavoro, specialmente nell’inferenza (ovvero l’utilizzo dell’AI, non il suo addestramento iniziale).

- Il vantaggio competitivo: Google controlla tutto lo stack verticale. Disegna il chip, possiede il software di ottimizzazione, gestisce il data center e offre il servizio cloud. Questo permette di bypassare i margini mostruosi di Nvidia.

- Il ritorno dei margini Cloud: Il settore cloud sta passando da un oligopolio ad alto margine (50-70%) a un settore “commoditized” con margini compressi dai costi hardware di Nvidia. Chi possiede il proprio silicio (ASIC) può riportare i margini a livelli sani.

I problemi di adozione e il futuro

Non è tutto oro quel che luccica. Nvidia rimane dominante per un motivo: CUDA. Il software di Nvidia è radicato nelle università e nelle aziende. Passare alle TPU richiede un adattamento del codice e, spesso, l’utilizzo dell’infrastruttura Google Cloud (GCP), creando un rischio di vendor lock-in (rimanere bloccati con un fornitore). Inoltre, per il training dei modelli più complessi, la flessibilità delle GPU è ancora spesso preferita.

Tuttavia, per colossi come Meta che spendono miliardi in inferenza (far girare l’algoritmo per miliardi di utenti ogni giorno), l’efficienza energetica ed economica delle TPU è un canto delle sirene irresistibile. Quindi Meta si rivolgerà anche verso Google, almeno sino a quando non svilupperà le proprie schede ASIC, forse la soluzione più ovvia, ma più costosa, nel medio-lungo termine. Una soluzione adatta alle richieste d’elaborazione della AI di Meta.

Verso un mercato più maturo

Siamo di fronte a una classica evoluzione industriale. La fase della “corsa all’oro” disordinata sta lasciando spazio alla fase dell’ottimizzazione dei costi e alla ricerca di una minore dipendenza da un singolo fornitore.

Se l’accordo Meta-Google andrà in porto, sancirà che nel lungo periodo l’AI diventerà una questione di efficienza energetica e specializzazione hardware.

Nvidia non sparirà, tutt’altro, ma il suo vantaggio competitivo potrebbe essere meno profondo di quanto gli investitori più entusiasti credano. Google, con la sua pazienza ingegneristica e la sua visione di lungo periodo sui chip custom, si sta posizionando non solo come un gigante del software, ma come l’architetto dell’infrastruttura fisica del futuro AI. E questo, in un’ottica di portafoglio e di strategia industriale, è il vero dato da osservare.

Domande e risposte

Perché Meta dovrebbe usare i chip di Google se ha già comprato migliaia di GPU Nvidia? È una questione di diversificazione e costi. Affidarsi a un solo fornitore (Nvidia) è rischioso e costoso, dato che Nvidia ha margini altissimi e problemi di fornitura. Le TPU di Google sono progettate specificamente per l’efficienza energetica nell’AI. Per un’azienda come Meta, che deve gestire miliardi di operazioni quotidiane, avere un’alternativa più efficiente per l’inferenza (l’esecuzione dei modelli) significa risparmiare miliardi in elettricità e hardware nel lungo periodo, riducendo la dipendenza da un monopolista.

Le TPU possono sostituire completamente le GPU di Nvidia? Al momento no. Le GPU Nvidia sono processori “generalisti” estremamente flessibili, supportati da un ecosistema software (CUDA) che è lo standard globale per gli sviluppatori. Le TPU sono “ASIC”, chip creati su misura per carichi di lavoro specifici di Google (TensorFlow/JAX). Mentre le TPU sono imbattibili per efficienza in certi compiti di Google e per l’inferenza su larga scala, le GPU restano preferibili per la ricerca, lo sviluppo e il training di nuovi modelli dove serve massima flessibilità.

Quali sono le implicazioni per gli investitori di Nvidia e Google? Per Nvidia, la notizia segnala che i suoi più grandi clienti (Big Tech) stanno cercando attivamente alternative per erodere il suo potere di prezzo. Questo potrebbe comprimere i margini futuri e aumentare la volatilità del titolo. Per Google (Alphabet), è una vittoria strategica enorme: valida la sua tecnologia hardware, apre un nuovo flusso di ricavi dalla vendita/affitto di chip a terzi e rafforza la sua posizione nel mercato Cloud, offrendo un vantaggio competitivo strutturale sui costi rispetto a chi deve comprare hardware da Nvidia.

You must be logged in to post a comment Login