Economia

Il Blackout di Cloudflare: Quando un “Permesso” sbagliato manda in Tilt mezzo Internet

Cloudflare in tilt ha quasi chiuso Internet: la spiegazione dell’errore (non è un hacker!)

Il 18 novembre 2025, un evento ha ricordato a tutti, dagli smanettoni ai semplici utenti, quanto la moderna infrastruttura di Internet sia tanto potente quanto fragile. Cloudflare, la società che funge da “guardiano” e acceleratore per una porzione massiccia del traffico web mondiale, è finita letteralmente in panne.1 Non per un attacco hacker, per fortuna, ma per un errore che potremmo definire, con un pizzico di amara ironia, da “permessi negati”.

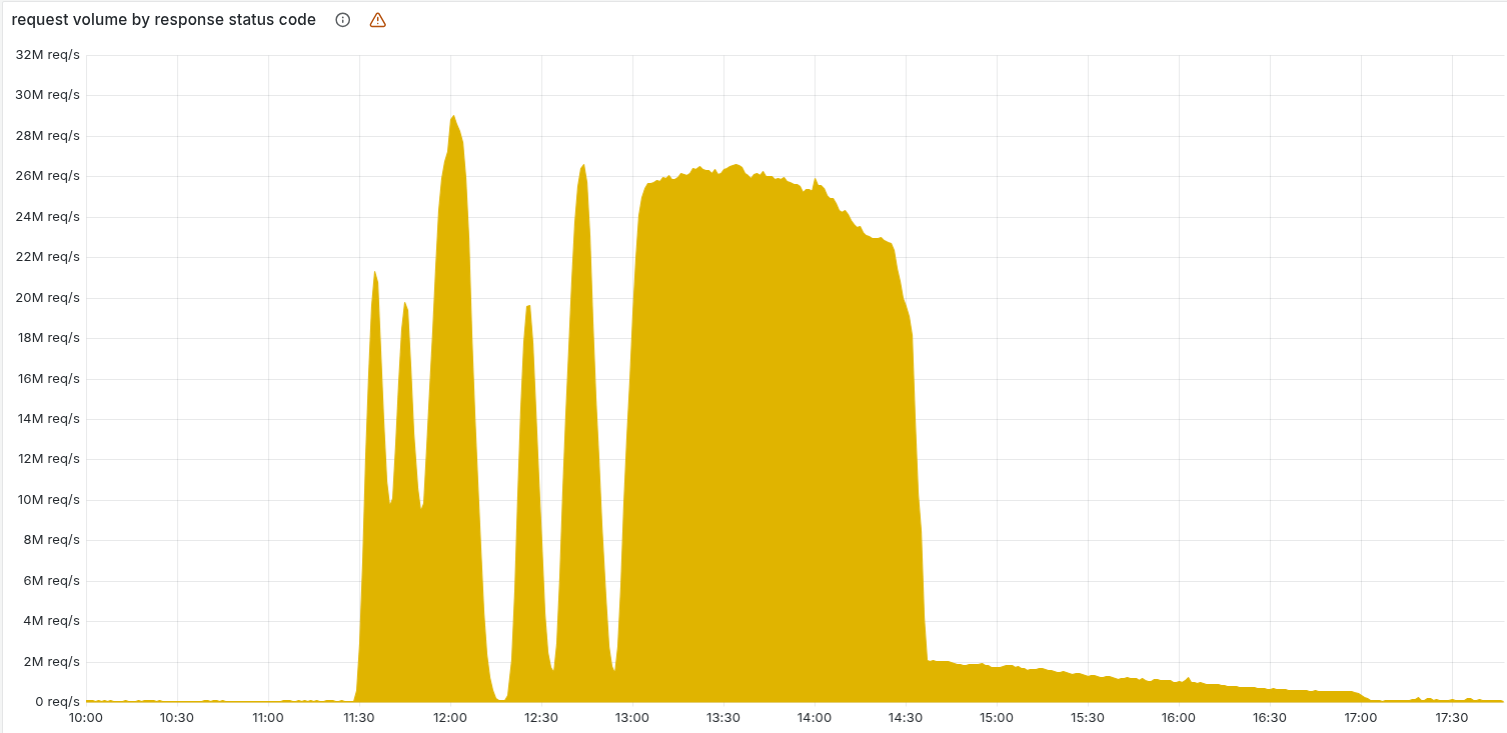

La durata dell’incidente (dalle 11:20 UTC fino al completo ripristino alle 17:06 UTC) non è stata un record, ma l’impatto sul traffico di rete è stato significativo, con un picco di errori HTTP 5xx (quelli del tipo “errore del server”) che ha fatto tremare i polsi a molti.

💥 La vera causa: Un file feature “ingrassato”

Contrariamente ai primi sospetti che puntavano a un maxi-attacco DDoS (Distributed Denial of Service) — l’abituale spauracchio dei colossi del web — il problema è stato generato da una banale, ma fatale, modifica di permessi in un sistema di database basato su ClickHouse.

Questa modifica, volta a migliorare la sicurezza e l’affidabilità delle query distribuite, ha avuto un effetto collaterale inatteso:

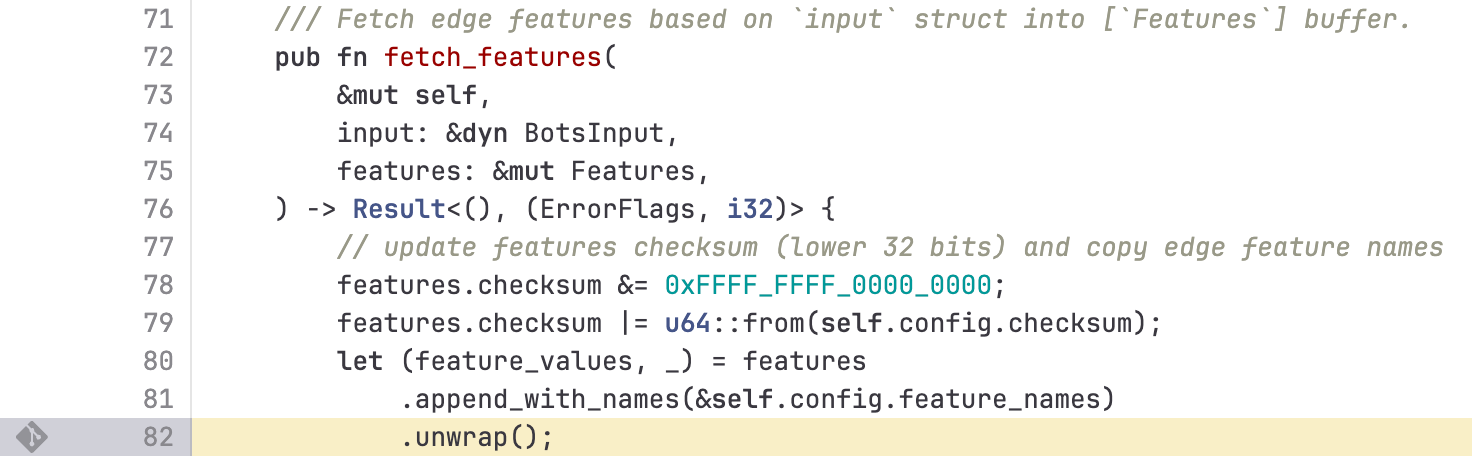

- Una query del sistema di Bot Management (gestione del traffico automatico) di Cloudflare ha iniziato a restituire un numero doppio di righe contenenti le “feature” (caratteristiche) utilizzate dai modelli di machine learning per distinguere un utente vero da un bot. Praticamente ha raddoppiato i file e le domande.

- Questo ha portato alla generazione di un “feature file” la cui dimensione era più che raddoppiata rispetto al previsto.

- Il file sovradimensionato è stato propagato rapidamente a tutte le macchine della rete Cloudflare.

- Il software del core proxy (FL/FL2) che gestisce il traffico aveva un limite di dimensione per questo file (fissato, per ottimizzazione delle performance, a 200 feature) e, superandolo, è andato in panic (un errore fatale nel linguaggio di programmazione Rust).

- Il risultato? L’interruzione della capacità di instradare il traffico fondamentale per i clienti, manifestatasi con le famigerate pagine di errore 5xx.

🔄 Un andamento ad “onda” che ha confuso le acque

Ciò che ha reso la diagnosi un vero e proprio rompicapo, tanto da far pensare a un attacco, è stata la natura intermittente dell’errore. La generazione del file feature avveniva ogni cinque minuti. Poiché la modifica dei permessi era in fase di roll-out graduale, a volte veniva generato un file buono e a volte un file cattivo.

Il sistema riprendeva per un breve periodo e poi falliva di nuovo, in un ciclo altalenante che assomigliava molto al comportamento irregolare e massivo di un attacco cibernetico. Solo quando tutti i nodi ClickHouse hanno iniziato a produrre il file difettoso, lo stato di fallimento si è stabilizzato, permettendo al team di individuare finalmente la radice del problema.

📉 I servizi chiave colpiti

L’incidente non è stato confinato a un singolo angolo della rete, ma ha avuto ripercussioni a cascata, toccando molti servizi vitali:

| Servizio/Prodotto | Descrizione dell’Impatto Principale |

| CDN e Sicurezza Core | Status code HTTP 5xx, interruzione del flusso di traffico. |

| Workers KV & Access | Aumento degli errori 5xx e fallimenti diffusi nell’autenticazione. |

| Dashboard | Difficoltà di accesso a causa del malfunzionamento del sistema Turnstile (Captcha di Cloudflare) sulla pagina di login. |

| Email Security | Temporanea riduzione dell’accuratezza nell’individuazione dello spam per la perdita di una fonte di reputazione IP. |

È degno di nota come persino la pagina di stato di Cloudflare, ospitata deliberatamente su un’infrastruttura esterna e indipendente per garantire la comunicazione in caso di guasto, sia risultata irraggiungibile per una pura (e sfortunata) coincidenza, amplificando i timori interni di un attacco coordinato. Evidentemente anche il server esterno utilizzava Cloudflare, ma questo ha impedito ai gestori dei server di sganciarsi dal servizio quando questo è diventato tossico!

💡 Lezione: mai più errori di sottovalutazione, ma quanto è fragile il Web

L’amministratore delegato, Matthew Prince, ha riconosciuto l’inaccettabilità di un’interruzione di questa portata, la peggiore dal 2019. L’errore, in sostanza, risiede in una mancanza di “robustezza” nel codice che non ha saputo gestire un input inatteso, sebbene generato internamente. Non si trattava di un input esterno malevolo, ma di un file di configurazione generato da Cloudflare stessa.

La risoluzione è arrivata bloccando la propagazione del file feature cattivo e inserendo manualmente una versione buona e funzionante.

Il piano di rimedio futuro è chiaro: fortificare i sistemi di ingestione dei file di configurazione generati internamente, proprio come si farebbe per un input generato da un utente, implementare interruttori globali (kill switches) più efficaci per le funzionalità critiche e rivedere tutte le modalità di failure per evitare che un errore in un modulo faccia panicare l’intero proxy. Una lezione di umiltà tecnologica, dove la corsa alle performance e all’ottimizzazione ha lasciato una piccola, ma letale, falla nella resilienza del sistema.

Nello stesso tempo l’errore successo a Cloudflare mostra la fragilità del sistema: il servizio è gratuito, o a basso costo rispetto al servizio reso. Questo ha portato a una sua diffusione quasi universale, ma la società che lo ha creato ha poi implementato modifiche del proprio software in modo superficiale, senza , ad esempio, testarlo in modo adeguato in un ambiente sicuro. Il fatto che non

Domande e Risposte

Che cosa sono gli errori HTTP 5xx e perché sono così importanti in questo contesto? Gli errori HTTP 5xx (in particolare il 500, “Internal Server Error”) indicano un problema sul server che gestisce la richiesta, non sul dispositivo dell’utente.2 Nel caso di Cloudflare, il sistema di core proxy (il cuore del loro servizio) è andato in panic, impedendogli di instradare correttamente il traffico e facendo apparire queste pagine di errore agli utenti che cercavano di accedere ai siti dei loro clienti. L’elevato volume di 5xx ha segnalato il completo collasso temporaneo della capacità di gestione del traffico di Cloudflare.

Perché un semplice cambiamento di permessi nel database ha causato un guasto così esteso? La causa è stata una reazione a catena inaspettata. La modifica dei permessi su un database ClickHouse ha fatto sì che una query interna per il sistema di Bot Management restituisse dati duplicati. Questo ha gonfiato il file di configurazione (feature file) usato per l’analisi dei bot. Il software di core proxy che caricava questo file aveva un limite rigido di memoria preallocata (un’ottimizzazione per la performance). Quando il file “gonfiato” ha superato tale limite, il software è andato in crash (panic), interrompendo il servizio su una scala globale.

Qual è la differenza di impatto tra gli utenti sulla vecchia (FL) e la nuova (FL2) versione del proxy Cloudflare? Il malfunzionamento ha colpito entrambe le versioni del proxy, ma in modi diversi. Gli utenti sulla nuova versione (FL2) hanno subito l’interruzione completa del servizio, visualizzando gli errori HTTP 5xx. Gli utenti sulla vecchia versione (FL) non hanno visto gli errori 5xx, ma il loro sistema di Bot Management non è riuscito a generare punteggi bot corretti (risultato zero). Questo ha portato a un gran numero di “falsi positivi” per i clienti che avevano regole per bloccare i bot con punteggio zero, bloccando di fatto anche il traffico legittimo.

You must be logged in to post a comment Login