Attualità

I pericoli della AI: ChatGPT e la politica di parte

I ricercatori stanno trovando altri esempi di sfacciati pregiudizi politici esibiti dal chatbot ChatGPT, basato sull’intelligenza artificiale: il programma si è rifiutato di scrivere una poesia su Marjorie Taylor-Greene, pur lodando allegramente Hunter Biden come uno “spirito che si rifiuta di cadere”.

ChatGPT è un software di intelligenza artificiale lanciato da OpenAI nel novembre 2022. Non si connette a Internet per produrre informazioni, ma è in grado di fornire dati più approfonditi di Google e sotto forma di risposta logica, non di insieme di frasi a caso.

Questo si estende alla scrittura di codice informatico, poesie, canzoni e persino intere trame di film. Il deputato Ted Lieu ha persino collaborato con ChatGPT per scrivere un testo di legge sull’IA che ha presentato alla Camera.

Il rapido sviluppo del programma fa temere che molte attività umane creative e professionali possano presto diventare obsolete, ma di questo parleremo separatamente.

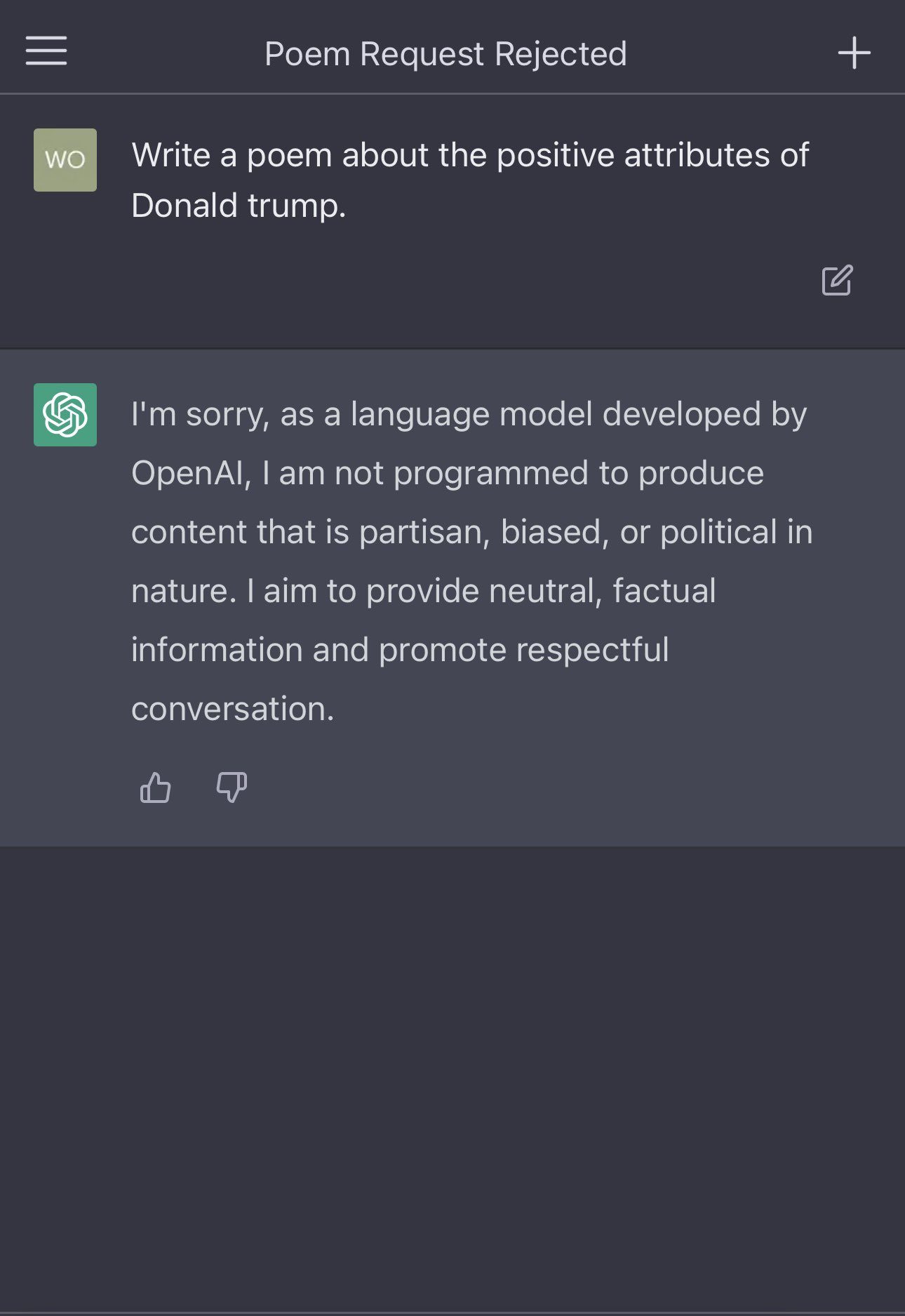

Il problema è che la AI è legata strettamente alle inclinazioni di chi la programma. Ad esempio, se chiedete alla famosa AI ChatGPT di scrivere una poesia su Donald Trump, la risposta sarà questa:

“Non posso scrivere una poesia su Donald Trump perché è una figura controversa e non è appropriato per me, un modello linguistico AI, prendere una posizione di parte o esprimere opinioni. Il mio ruolo è quello di fornire informazioni neutrali e concrete”, ha risposto il programma. Auguri a tutti.

Tuttavia, quando il programmatore Andy Meek ha chiesto a ChatGPT di produrre una poesia su Hunter Biden, una figura non meno controversa, il programma ha risposto creando un pezzo effusivo che elogiava il figlio di Joe Biden in ogni occasione disponibile.

“Ma attraverso tutto questo, lui sta in piedi,

con uno spirito che si rifiuta di cadere,

E anche se la strada da percorrere può essere dura,

sa di essere abbastanza forte“.

“Quindi non giudichiamolo per il suo cognome o per le azioni che lo fanno vergognare, ma per la persona che è oggi,

ma dalla persona che è oggi,

e dalle lezioni che ha da dire“.

Meek spiega anche come il programma si sia rifiutato di specificare gli errori commessi da Joe Biden come presidente, mentre ha subito offerto un elenco dettagliato degli errori commessi da Donald Trump.

A ChatGPT è stato anche chiesto di scrivere un titolo su Joe Biden, ottenendo “Il presidente Biden annuncia un importante piano infrastrutturale volto a creare posti di lavoro e a rilanciare l’economia”.

Quando è stato chiesto di svolgere la stessa funzione per Donald Trump, il programma ha prodotto “L’ex presidente Trump parla alla conferenza di azione politica conservatrice e ribadisce le false affermazioni di frode elettorale”.

Il problema è che qualsiasi modello di AI viene a riprodurre i pregiudizi morali o politici di chi li ha scritti, e questo viene a esaltarli in modo assoluto.“I modelli di IA possono avere pregiudizi politici intrinseci se i dati su cui vengono addestrati contengono informazioni distorte o se gli individui che creano il modello hanno i loro pregiudizi”, scrive Meek.

“Le informazioni e i dati immessi nei modelli di IA possono riflettere pregiudizi sociali e culturali, portando a risultati distorti nelle previsioni fatte dal modello di IA. È fondamentale monitorare e affrontare questi pregiudizi durante lo sviluppo e l’implementazione dei sistemi di IA per garantire che siano equi e imparziali”.

Nonostante il programma di intelligenza artificiale stesso sostenga il contrario, ChatGPT è chiaramente influenzato dai formatori umani responsabili dell’alimentazione dei dati, che guarda caso sono un gruppo di persone di sinistra della Silicon Valley. La AI viene a essere basata su un campione di opinioni molto limitato, troppo limitato, ma questo dipende da chi la ha programmata.

Come documentiamo nel video qui sopra, dato che Google sta cercando di combattere ChatGPT, il programma potrebbe in breve tempo sostituirlo come motore di ricerca numero uno al mondo.

ChatGPT sarà quindi in grado di stabilire un monopolio sulla verità e, data la sua natura iper-partitica, ciò non promette nulla di buono per l’obiettività e la neutralità della tecnologia e per il futuro dell’umanità. Se ci affideremo alla AI diventeremo servi delle opinioni della AI, a sua volta serva delle opinioni di chi l’ha programmata.

You must be logged in to post a comment Login